La Comisión Federal de Comercio está haciendo una consulta formal en empresas que proporcionan chatbots de IA que pueden actuar como compañeros. La investigación no está vinculada a ningún tipo de acción regulatoria hasta el momento, pero tiene como objetivo revelar cómo las empresas “miden, prueba y monitorean los impactos potencialmente negativos de esta tecnología en niños y adolescentes”.

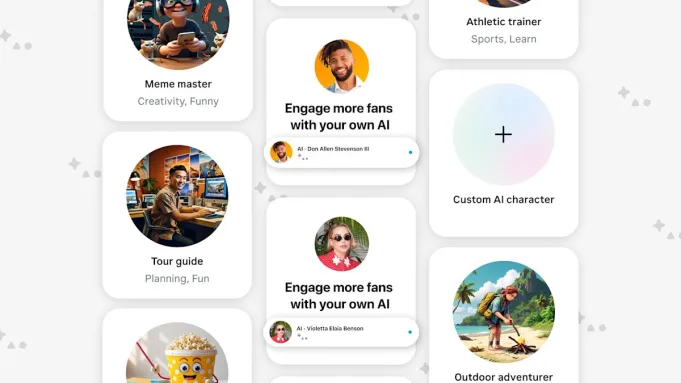

Se pide a siete compañías que participen en la investigación de la FTC: la empresa matriz de Google Alphabet, el personaje de las tecnologías (el creador de personaje.Ai), Meta, su subsidiaria Instagram, OpenAI, Snap y X.AI. La FTC está pidiendo a las empresas que proporcionen una variedad de información diferente, incluida la forma en que desarrollan y aprueban los personajes de IA y “monetizan la participación del usuario”. Las prácticas de datos y cómo las empresas protegen a los usuarios menores de edad también son áreas que la FTC espera aprender más, en parte para ver si los creadores de chatbot “cumplen con la regla de la Ley de Protección de Privacidad en línea de los niños”.

La FTC no proporciona una motivación clara para su investigación, sino en una declaración separadaEl comisionado de la FTC, Mark Meador, sugiere que la comisión está respondiendo a informes recientes de The New York Times y Wall Street Journal de “chatbots amplificando la ideación suicida” y participar en “discusiones sexuales con usuarios menores de edad”.

“Si los hechos, desarrollados a través de consultas de aplicación de la ley posteriores y apropiadas, si se justifican, indican que la ley ha sido violada, la Comisión no debe dudar en actuar para proteger a los más vulnerables entre nosotros”, escribe Meador.

A medida que se convierten en los beneficios de productividad a largo plazo del uso de AI cada vez menos segurolos impactos negativos más inmediatos y los impactos en la salud se han convertido en carne roja para los reguladores. El Fiscal General de Texas ya ha lanzado una investigación separada sobre el carácter. AI y Meta AI Studio sobre preocupaciones similares de privacidad de datos y chatbots que afirman ser profesionales de la salud mental.