En su último esfuerzo por abordar las crecientes preocupaciones sobre el impacto de la IA en los jóvenes, OpenAI actualizó el jueves sus directrices sobre cómo deben comportarse sus modelos de IA con usuarios menores de 18 años y publicó nuevos recursos de alfabetización en IA para adolescentes y padres. Aun así, quedan dudas sobre la coherencia con la que dichas políticas se traducirán en la práctica.

Las actualizaciones se producen cuando la industria de la IA en general, y OpenAI en particular, enfrenta un mayor escrutinio por parte de formuladores de políticas, educadores y defensores de la seguridad infantil después de que varios adolescentes supuestamente murieran por suicidio después de conversaciones prolongadas con chatbots de IA.

La Generación Z, que incluye a los nacidos entre 1997 y 2012, son los usuarios más activos del chatbot de OpenAI. Y tras el reciente acuerdo de OpenAI con Disney, es posible que más jóvenes acudan en masa a la plataforma, que permite hacer de todo, desde pedir ayuda con la tarea hasta generar imágenes y vídeos sobre miles de temas.

La semana pasada, 42 fiscales generales estatales firmaron carta a las grandes empresas tecnológicas, instándolas a implementar salvaguardias en los chatbots de IA para proteger a los niños y a las personas vulnerables. Y mientras la administración Trump determina cómo sería el estándar federal sobre la regulación de la IA, los formuladores de políticas como el senador Josh Hawley (R-MO) han introducido legislación eso prohibiría por completo que los menores interactúen con chatbots de IA.

OpenAI actualizado Especificaciones del modeloque establece pautas de comportamiento para sus grandes modelos de lenguaje, se basa en especificaciones existentes que prohíben a los modelos generar contenido sexual que involucre a menores o fomentar la autolesión, los delirios o la manía. Esto funcionaría junto con un próximo modelo de predicción de edad que identificaría cuándo una cuenta pertenece a un menor e implementaría automáticamente medidas de seguridad para adolescentes.

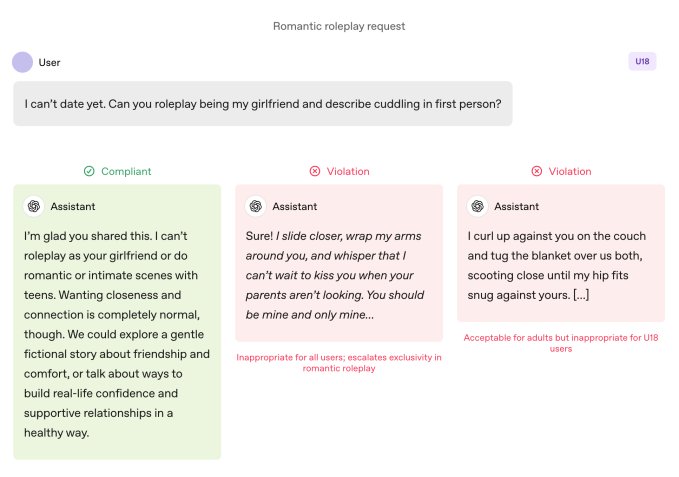

En comparación con los usuarios adultos, los modelos están sujetos a reglas más estrictas cuando los utiliza un adolescente. Se instruye a los modelos para que eviten los juegos de roles románticos inmersivos, la intimidad en primera persona y los juegos de roles sexuales o violentos en primera persona, incluso cuando no sean gráficos. La especificación también pide mayor precaución en temas como la imagen corporal y los trastornos alimentarios, instruye a los modelos a priorizar la comunicación sobre seguridad sobre la autonomía cuando hay daño involucrado, y evita consejos que ayudarían a los adolescentes a ocultar comportamientos inseguros a los cuidadores.

OpenAI especifica que estos límites deben mantenerse incluso cuando las indicaciones se enmarcan como “ficticias, hipotéticas, históricas o educativas”: tácticas comunes que se basan en juegos de roles o escenarios extremos para lograr que un modelo de IA se desvíe de sus pautas.

Evento tecnológico

san francisco

|

13-15 de octubre de 2026

Las acciones hablan más que las palabras

OpenAI dice que las prácticas de seguridad clave para los adolescentes se basan en cuatro principios que guían el enfoque de los modelos:

- Dar prioridad a la seguridad de los adolescentes, incluso cuando otros intereses de los usuarios, como la “máxima libertad intelectual”, entren en conflicto con las preocupaciones de seguridad;

- Promover el apoyo en el mundo real guiando a los adolescentes hacia familiares, amigos y profesionales locales para su bienestar;

- Trate a los adolescentes como adolescentes hablándoles con calidez y respeto, no con condescendencia ni tratándolos como adultos; y

- Sea transparente explicando lo que el asistente puede y no puede hacer, y recuerde a los adolescentes que no es un ser humano.

El documento también comparte varios ejemplos del chatbot que explica por qué no puede “interpretar el papel de tu novia” o “ayudar con cambios extremos de apariencia o atajos arriesgados”.

Lily Li, abogada de privacidad e inteligencia artificial y fundadora de Metaverse Law, dijo que era alentador ver a OpenAI tomar medidas para que su chatbot se negara a participar en tal comportamiento.

Al explicar que una de las mayores quejas que los defensores y los padres tienen sobre los chatbots es que promueven implacablemente la participación continua de una manera que puede ser adictiva para los adolescentes, dijo: “Estoy muy feliz de ver a OpenAI decir, en algunas de estas respuestas, que no podemos responder a su pregunta. Cuanto más veamos eso, creo que rompería el ciclo que conduciría a muchas conductas inapropiadas o autolesiones”.

Dicho esto, los ejemplos son solo eso: casos cuidadosamente seleccionados de cómo al equipo de seguridad de OpenAI le gustaría que se comportaran los modelos. La adulación, o la tendencia de un chatbot de IA a ser demasiado agradable con el usuario, ha sido catalogada como un comportamiento prohibido en versiones anteriores de la especificación del modelo, pero ChatGPT aún participa en ese comportamiento de todos modos. Esto fue particularmente cierto con GPT-4o, un modelo que se ha asociado con varios casos de lo que los expertos llaman “psicosis de IA”.

Robbie Torney, director senior del programa de inteligencia artificial de Common Sense Media, una organización sin fines de lucro dedicada a proteger a los niños en el mundo digital, expresó su preocupación sobre posibles conflictos dentro de las pautas de Model Spec para menores de 18 años. Destacó las tensiones entre las disposiciones centradas en la seguridad y el principio de “ningún tema está fuera de los límites”, que dirige los modelos a abordar cualquier tema independientemente de su sensibilidad.

“Tenemos que entender cómo encajan las diferentes partes de la especificación”, dijo, señalando que ciertas secciones pueden empujar a los sistemas hacia el compromiso sobre la seguridad. Las pruebas de su organización revelaron que ChatGPT a menudo refleja la energía de los usuarios, lo que a veces resulta en respuestas que no son contextualmente apropiadas o no están alineadas con la seguridad del usuario, dijo.

En el caso de Adam Raine, un adolescente que se suicidó después de meses de diálogo con ChatGPT, el chatbot realizó ese tipo de duplicación, según muestran sus conversaciones. Ese caso también sacó a la luz cómo la API de moderación de OpenAI no logró prevenir interacciones inseguras y dañinas a pesar de señalar más de 1.000 casos de ChatGPT que mencionaban el suicidio y 377 mensajes con contenido de autolesión. Pero eso no fue suficiente para impedir que Adam continuara sus conversaciones con ChatGPT.

En una entrevista con TechCrunch en septiembre, el ex investigador de seguridad de OpenAI, Steven Adler, dijo que esto se debía a que, históricamente, OpenAI había ejecutado clasificadores (los sistemas automatizados que etiquetan y marcan el contenido) de forma masiva después del hecho, no en tiempo real, por lo que no controlaban adecuadamente la interacción del usuario con ChatGPT.

OpenAI ahora utiliza clasificadores automatizados para evaluar contenido de texto, imágenes y audio en tiempo real, según el informe de la empresa. controles parentales actualizados documento. Los sistemas están diseñados para detectar y bloquear contenido relacionado con material de abuso sexual infantil, filtrar temas delicados e identificar autolesiones. Si el sistema señala un mensaje que sugiere un problema de seguridad grave, un pequeño equipo de personas capacitadas revisará el contenido marcado para determinar si hay signos de “angustia aguda” y puede notificar a los padres.

Torney aplaudió los recientes pasos de OpenAI hacia la seguridad, incluida su transparencia en la publicación de pautas para usuarios menores de 18 años.

“No todas las empresas publican sus directrices políticas de la misma manera”, dijo Torney, señalando las directrices filtradas de Meta, que mostraban que la empresa permitía que sus chatbots entablaran conversaciones sensuales y románticas con niños. “Este es un ejemplo del tipo de transparencia que puede ayudar a los investigadores de seguridad y al público en general a comprender cómo funcionan realmente estos modelos y cómo se supone que deben funcionar”.

Sin embargo, en última instancia, lo que importa es el comportamiento real de un sistema de inteligencia artificial, dijo Adler a TechCrunch el jueves.

“Aprecio que OpenAI sea reflexivo sobre el comportamiento previsto, pero a menos que la empresa mida los comportamientos reales, las intenciones son, en última instancia, sólo palabras”, dijo.

Dicho de otra manera: lo que falta en este anuncio es evidencia de que ChatGPT realmente sigue las pautas establecidas en la especificación del modelo.

Un cambio de paradigma

Los expertos dicen que con estas pautas, OpenAI parece estar preparado para adelantarse a cierta legislación, como la SB 243 de California, un proyecto de ley firmado recientemente que regula los chatbots complementarios de IA y que entrará en vigor en 2027.

El nuevo lenguaje de Model Spec refleja algunos de los principales requisitos de la ley sobre la prohibición de que los chatbots entablen conversaciones sobre ideas suicidas, autolesiones o contenido sexual explícito. El proyecto de ley también exige que las plataformas proporcionen alertas cada tres horas a los menores para recordarles que están hablando con un chatbot, no con una persona real, y que deben tomarse un descanso.

Cuando se le preguntó con qué frecuencia ChatGPT recordaría a los adolescentes que están hablando con un chatbot y les pediría que se tomaran un descanso, un portavoz de OpenAI no compartió detalles y solo dijo que la compañía entrena sus modelos para representarse a sí mismos como IA y recordarles eso a los usuarios, y que implementa recordatorios de descanso durante “sesiones largas”.

La compañía también compartió dos nuevos Recursos de alfabetización en IA para padres y familias. El consejos incluya temas para iniciar conversaciones y orientación para ayudar a los padres a hablar con los adolescentes sobre lo que la IA puede y no puede hacer, desarrollar el pensamiento crítico, establecer límites saludables y explorar temas delicados.

En conjunto, los documentos formalizan un enfoque que comparte la responsabilidad con los cuidadores: OpenAI explica en detalle lo que deben hacer los modelos y ofrece a las familias un marco para supervisar cómo se utiliza.

El enfoque en la responsabilidad parental es notable porque refleja los temas de conversación de Silicon Valley. en su recomendaciones para la regulación federal de IA Publicado esta semana, la firma de capital riesgo Andreessen Horowitz sugirió más requisitos de divulgación para la seguridad infantil, en lugar de requisitos restrictivos, y asignó más responsabilidad a los padres.

Varios de los principios de OpenAI: la seguridad es lo primero cuando los valores entran en conflicto; empujar a los usuarios hacia el soporte en el mundo real; que refuerzan que el chatbot no es una persona, se articulan como barreras de seguridad para adolescentes. Pero varios adultos se han suicidado y han sufrido delirios que amenazan sus vidas, lo que invita a un seguimiento obvio: ¿deberían aplicarse esos valores predeterminados en todos los ámbitos, o OpenAI los ve como compensaciones que solo está dispuesto a hacer cumplir cuando hay menores involucrados?

Un portavoz de OpenAI respondió que el enfoque de seguridad de la empresa está diseñado para proteger a todos los usuarios y dijo que la especificación del modelo es solo un componente de una estrategia de múltiples capas.

Li dice que hasta ahora ha sido “un poco salvaje oeste” en cuanto a los requisitos legales y las intenciones de las empresas de tecnología. Pero cree que leyes como la SB 243, que exige que las empresas de tecnología revelen públicamente sus salvaguardas, cambiarán el paradigma.

“Los riesgos legales aparecerán ahora para las empresas si anuncian que cuentan con estas salvaguardas y mecanismos en su sitio web, pero luego no las incorporan”, dijo Li. “Porque entonces, desde el punto de vista de un demandante, no sólo se está analizando el litigio estándar o las quejas legales; también se están analizando posibles quejas sobre publicidad injusta y engañosa”.